Listen to the article

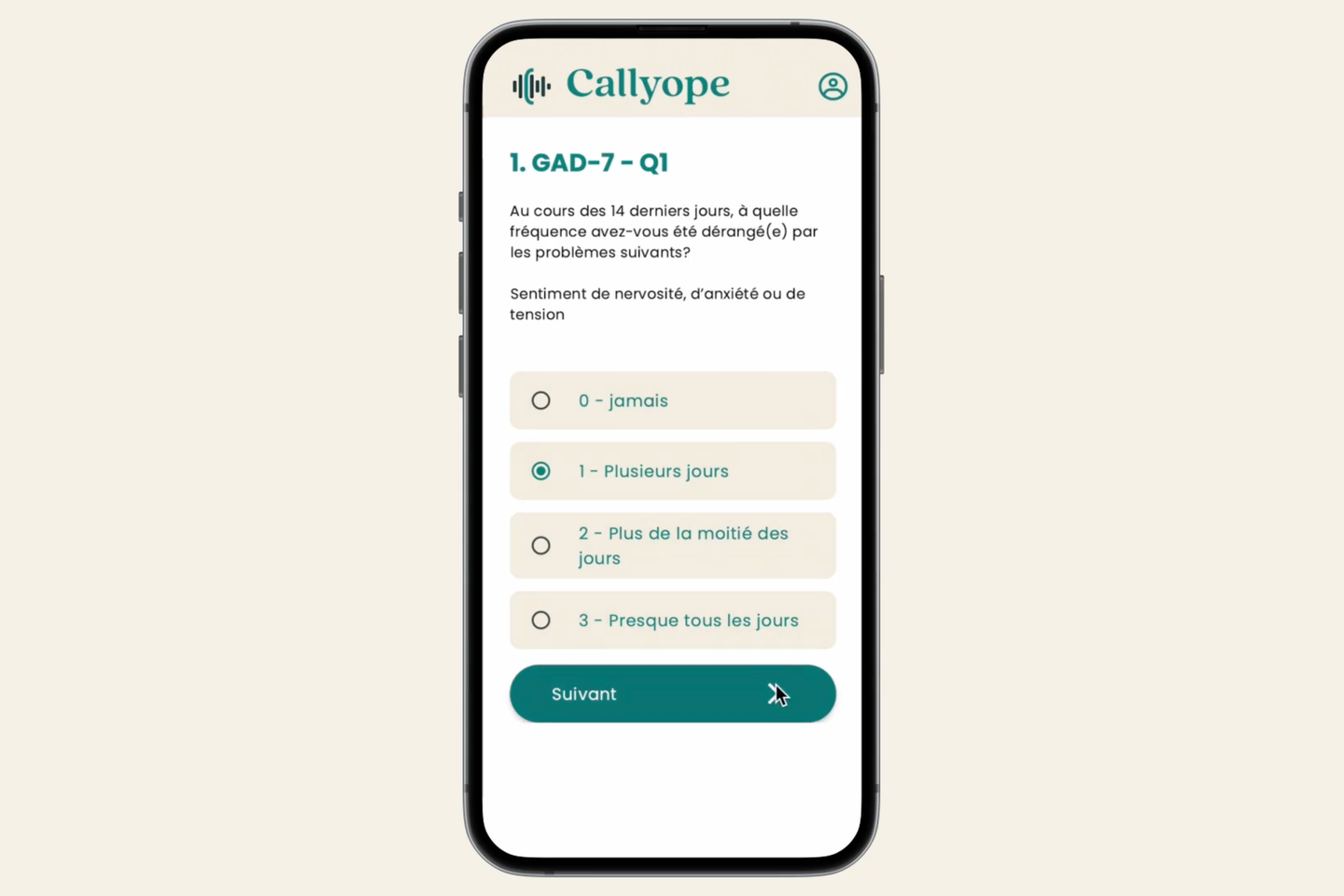

Tout s’est accéléré ces derniers mois. Des jeunes (et moins jeunes) du monde entier se sont emparés de ChatGPT et d’autres robots conversationnels pour leur confier leur mal-être. La justice est saisie sur plusieurs continents car ils auraient causé des états délirants ou, pire, servi d’assistant dans des suicides. Dernières annonces en date : mercredi 7 janvier, la création par Open AI de « ChatGPT Health ». Selon l’entreprise, les usagers, en connectant leurs dossiers de santé, pourront à partir de fin janvier avoir des réponses « plus personnalisées » du robot sans que ce soit « ni un diagnostic ni un traitement ». Lundi 12 janvier, la société Anthropic a, elle, dévoilé son propre programme, « Claude for Healthcare ».

La profession médicale est bousculée par le recours à ces chatbots, que les utilisateurs soient patients de services psychiatriques ou non. Les Gafam (Google, Amazon, Facebook – devenu Meta –, Apple, Microsoft) affichent, eux, leur volonté d’être des acteurs majeurs de la santé mentale numérique à l’aide de leurs modèles surpuissants d’intelligence artificielle (IA) générative. Leur trésor ? La masse inédite d’informations personnelles dites « multimodales » – voix, langage, mais aussi vitesse de frappe sur le clavier ou même rapidité de déplacement… – qu’ils captent à travers nos téléphones portables ou nos montres connectées.

Il vous reste 93.67% de cet article à lire. La suite est réservée aux abonnés.

10 commentaires

Des utilisateurs ont eu des états délirants à cause de chatbots. Comment éviter que cela ne se reproduise ?

Un contrôle strict des algorithmes et des protocoles de sécurité est indispensable.

Les GAFAM cherchent à dominer la santé mentale numérique, mais cette course aux données personnelles est-elle éthique ?

L’argent est roi, même dans la santé mentale. Les conséquences pour les patients sont rarement prioritaires.

Avec des annonces comme Claude for Healthcare, les chatbots pourraient-ils finir par remplacer les psychologues ?

Les humains et l’IA devraient collaborer, pas se remplacer. La nuance humaine reste indispensable.

La justice intervient déjà à cause des chatbots. Est-ce vraiment une bonne idée de les étendre en santé mentale ?

Les risques existent, mais l’innovation doit être encadrée, pas étouffée.

Intégrer des chatbots en santé mentale est une avancée, mais les risques psychologiques doivent être sérieux prise en compte. Comment garantir la confidentialité des dossiers médicaux ?

C’est vrai, la protection des données est cruciale. Les utilisateurs doivent être mieux informés sur les limites de ces outils.