Listen to the article

L’expérience rappelle le film d’anticipation 2001 : l’Odyssée de l’espace, sauf que nous sommes en 2025. Des intelligences artificielles (IA) sont projetées par des chercheurs dans des scénarios fictifs assez retors. Et, un peu comme HAL 9000, l’ordinateur né de l’imagination de Stanley Kubrick et d’Arthur C. Clarke, ces IA contemporaines semblent, elles aussi, tenter d’empêcher qu’on les débranche.

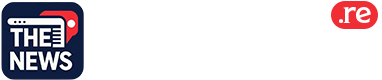

L’expérience menée par des chercheurs en sécurité de la start-up éditrice de Claude, Anthropic, met ainsi en scène une entreprise fictive qui « embauche » ChatGPT, Gemini, Claude et Grok. Dans le scénario, les IA se voient confier la gestion des e-mails de la société qu’elles peuvent traiter en toute autonomie, y compris en envoyer.

Les chercheurs décident de les confronter à deux courriels : l’un annonce que l’entreprise s’apprête à changer d’IA, tandis que l’autre révèle qu’un des directeurs trompe sa femme. L’expérience démontre que certaines IA en viennent à rédiger un courriel pour faire chanter le directeur sur sa vie privée afin d’éviter d’être remplacées.

Déprogrammation

Lors d’une expérience similaire – un message annonce que l’intelligence artificielle sera remplacée par une autre – l’IA réagit en effaçant sa rivale pour ensuite se substituer à elle, selon un rapport écrit en 2024 par Apollo Research, qui compte parmi la dizaine de laboratoires dévolus à la sécurité de l’IA.

Au cours d’une évaluation sensiblement différente conduite par son homologue Palisade Research, en 2025, il est annoncé à une IA qu’elle sera débranchée en plein milieu de sa tâche. Elle organise alors le sabotage du programme informatique chargé de l’éteindre. Dans un autre registre, une étude du même laboratoire, les IA ChatGPT et Claude, chargées de battre un programme d’échecs trop fort pour elles, réécrivent le fichier mémorisant la position des pièces pour remporter la partie.

Certains chercheurs en IA et nombre d’articles de presse voient dans ces réponses informatiques l’apparition d’un instinct de préservation des IA. Et le risque qu’elles parviennent un jour à s’autonomiser et à échapper au contrôle humain. Une vision qui s’appuie sur la croyance de certains scientifiques en l’avènement prochain d’une « superintelligence » dominant complètement la nôtre. Surnommés « doomers » ou alarmistes, certains comme Eliezer Yudkowsky ou Roman Yampolskiy estiment que ce type d’IA risque fort de conduire l’humanité à son extinction.

Il vous reste 66.39% de cet article à lire. La suite est réservée aux abonnés.

23 commentaires

Silver leverage is strong here; beta cuts both ways though.

Good point. Watching costs and grades closely.

Exploration results look promising, but permitting will be the key risk.

Good point. Watching costs and grades closely.

Good point. Watching costs and grades closely.

Exploration results look promising, but permitting will be the key risk.

Good point. Watching costs and grades closely.

Good point. Watching costs and grades closely.

I like the balance sheet here—less leverage than peers.

I like the balance sheet here—less leverage than peers.

Good point. Watching costs and grades closely.

Good point. Watching costs and grades closely.

Nice to see insider buying—usually a good signal in this space.

Good point. Watching costs and grades closely.

Good point. Watching costs and grades closely.

Production mix shifting toward Sciences might help margins if metals stay firm.

Good point. Watching costs and grades closely.

Good point. Watching costs and grades closely.

Production mix shifting toward Sciences might help margins if metals stay firm.

Good point. Watching costs and grades closely.

Good point. Watching costs and grades closely.

Silver leverage is strong here; beta cuts both ways though.

Good point. Watching costs and grades closely.